Niedawno gruchnęła informacja, że sztuczna inteligencja (AI) znajdzie zastosowanie w nowej dziedzinie. Wie o tym najlepiej JP Morgan, największy bank inwestycyjny świata, który ostatnio złożył wniosek o rejestrację znaku towarowego dla produktu IndexGPT. To może doprowadzić do poważnych zmian w świecie finansowym, o których mało komu jeszcze się śni. Na znaczeniu straciłby wówczas człowiek, a coraz częściej wykorzystywana byłaby na tym polu maszyna.

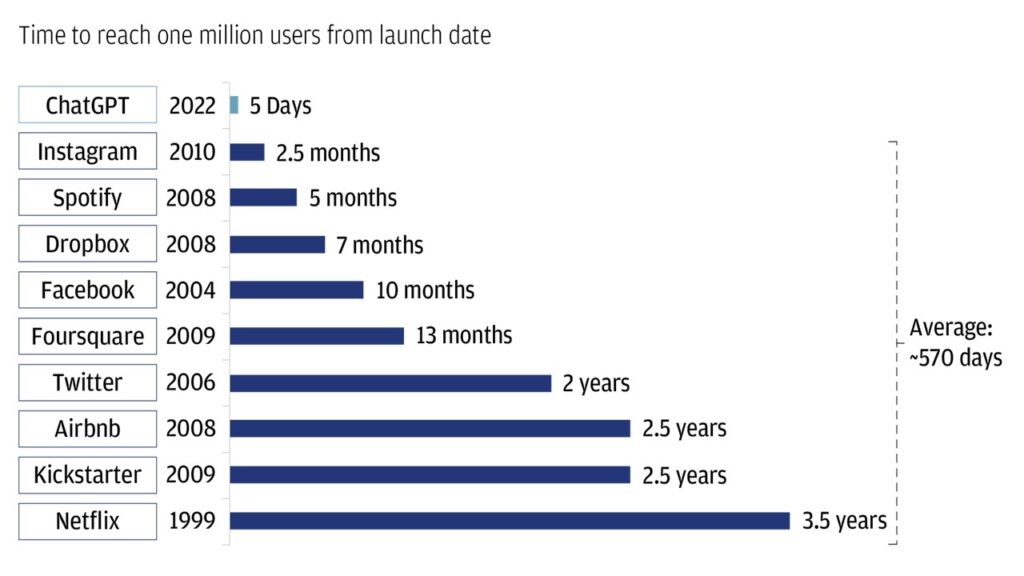

Przydatność technologii informatycznych można mierzyć na wiele sposobów. Jednym z nich jest powszechność korzystania. Im więcej osób to czyni, tym rozwiązanie przydatniejsze i zmienia ludzkie życie. Być może jeszcze lepszym sposobem jest analiza czasu, jaki zajmuje upowszechnienie technologii. Jest on naturalnie zróżnicowany, choć można przyjąć, że im szybciej coś zdobywa popularność, tym większe korzyści ludzie dostrzegają w jego stosowaniu. I tutaj ChatGPT nie ma sobie równych. Pierwszy milion użytkowników zyskał po 5 dniach od wdrożenia w listopadzie zeszłego roku. Dla porównania drugiemu na liście Instagramowi proces zabrał 2,5 miesiąca. Tempo zresztą nie słabło – tylko w styczniu tego roku aplikacja miała ponad 100 mln użytkowników z całego świata (najwięcej w Stanach Zjednoczonych, Indiach i Japonii).

Imponujący wzrost zainteresowania ChatGPT da się zauważyć też, gdy weźmie się pod lupę wyłącznie statystyki charakterystyczne dla niego – np. liczbę odsłon, która ilustruje intensywność korzystania z aplikacji. Jej start był w miarę „skromny” (nieco ponad 150 mln) – w kwietniu to już było 1,8 mld. Największy przyrost odsłon został odnotowany w marcu br. (+600 mln). To zapewne nie przypadek, gdyż wówczas zadebiutowała wersja 4.0 rozwiązania (wcześniej funkcjonowała wersja 3.5). Jest ona kolejnym postępem rozwojowym, ponieważ okazała się bardziej niezawodna niż jej poprzedniczka.

A postęp w dziedzinie AI jest błyskawiczny. Jeszcze przed miesiącami istniała wersja ChatGPT 3.0. Na jej bazie Cade Metz, reporter od technologii New York Times, wraz ze znanym mistrzem kuchni – Priya Krishna, podjęli się trudu stworzenia menu na Święto Dziękczynienia. Nie skończyło się to dobrze, łącznie ze sztandarowym daniem na amerykańskim stole podczas uroczystości, czyli pieczonym indykiem. Jeden z testerów przygotowanego dzięki GPT 3.0 menu był bezpośredni, podsumowując, że nie czuje się na siłach zjeść tych potraw. Wyglądało to tak, jakby dania stworzył szalony kucharz. To jednak okazało się przejawem choroby wieku młodzieńczego. Wersja 4.0 jest kolejnym krokiem ku postępowi sztucznej inteligencji. A do tego daje więcej możliwości w porównaniu z każdą ze swoich poprzedniczek. Kilka przykładów z brzegu. ChatGPT 4.0 uzyskał o 150 pkt. wyższy wynik w teście SAT niż wcześniejsza wersja. Jest o 40% bardziej skłonny do udzielania dokładnych odpowiedzi i może teraz akceptować wizualne dane wejściowe (a nie wyłącznie tekst). Najbardziej trafnie odpowiada po angielsku. Obecnie jest to na poziomie 85,5% – wcześniej było to 70,1%. A zatem poziom halucynacji, czyli omyłek aplikacji, znacząco się zmniejszył. Dla porządku warto dodać, że polski pod tym względem znajduje się w czołówce (9 miejsce) z 82,1% trafnością. Niestety brak dla naszego języka danych porównawczych. Więcej na temat statystyk najnowszej wersji ChatGPT znajdziesz TUTAJ.

Na GPT świat się nie kończy

Sztuczna inteligencja budzi bez wątpienia emocje – więcej na jej temat dowiesz się TUTAJ.

Bywają one dwubiegunowe. Z jednej strony niełatwo znaleźć giganta technologicznego, który nie wdrażałby swoich rozwiązań opartych na sztucznej inteligencji. Microsoft jest kojarzony z ChatGPT – od 2019 r. w kolejnych rundach finansowania wyłożył łącznie co najmniej 10 mld dol. (padają jednak w przestrzeni publicznej nawet nieco wyższe kwoty). Google ma nawet dwie aplikacje – flagowej Bard towarzyszy Socratic, który jest przeznaczony dla dzieci i studentów. Amazon wdrożył CodeWhisperer. Chińskie Baidu wprawdzie ogłosiło szumnie w marcu tego roku, że jego Ernie Bot jest gotowy, ale wygląda na to, że na tym się, póki co, skończyło – firma nie podała daty debiutu aplikacji. To wszystko przykłady systemów, które są wyspecjalizowane w odpowiedziach w formie pisemnej.

Są jednak i inne pomysły gigantów technologicznych. Meta wdrożyła w zeszłym roku Make-A-Scene. Aplikacja po otrzymaniu pisemnego polecenia odpowiada w formie obrazka. Należy mieć tylko nadzieję, że dysponuje ona jakimiś filtrami, które zabezpieczają przed pojawianiem się niepożądanych grafik małoletnim.

To nie koniec zmagań – niektórzy pracują nad systemem, w którym komendy wydaje się w formie ustnej, a AI odpowiada tekstowo. Zupełnie bym się nie zdziwił, gdyby całkiem niebawem myśl ludzka poszybowała w takim kierunku, że przemawiamy do urządzenia wyposażonego w AI, a ono nam też odpowiada, mówiąc do nas. A to może być pewne antidotum na samotność, która dręczy wielu ludzi.

Do tego, poza gigantami technologicznymi, dochodzi cała masa firm-klonów. Przypomina to nieco znaną w Polsce rywalizację w sektorze telefonii komórkowej. Tam przecież działają operatorzy wirtualnej sieci komórkowej (MVNO), którzy bazują na infrastrukturze konkurenta. Klony AI to podmioty, które są zbyt słabe finansowo i technologicznie, aby samodzielnie stworzyły nowe rozwiązanie w zakresie sztucznej inteligencji. Włączają się jednak do wyścigu. Uruchamiają aplikacje sygnowane własnymi markami, które bazują jednak na odkryciach gigantów – chodzi głównie o ChatGPT. Dzieje się tak, gdyż mało którą firmę stać na samodzielną, niezakłóconą badawczość w obszarze AI. Wszystko za sprawą tego, że aplikacje stają się coraz bardziej skomplikowane, a z pewnością skala trudności nie rośnie w tempie linearnym – bardziej przypomina wykładnicze. Wystarczy sobie uzmysłowić, że wydany w lutym 2019 r. GPT 2.0 miał 1,5 mld parametrów. GPT 3.0 to już było 175 mld parametrów. Wszystkich jednak przebił Google w zeszłym roku ze swoim nowym systemem sztucznej inteligencji – PaLM. Ten ma już 540 mld parametrów. Nic zatem dziwnego, że PaLM kosztował 160 razy więcej niż „staruszek” GPT 2.0. A to i tak nie jest najbardziej rozbudowany system AI na świecie – za taki uchodzi chińskie Wu Dao 2.0.

Inwestorzy najwyraźniej atrakcyjnie oceniają perspektywy rozwojowe branży sztucznej inteligencji, ponieważ od lat pieniądz płynie do niej wartkim strumieniem. 2022 r. był szczególny pod tym względem. Po raz pierwszy od dobrych kilku lat doszło do pewnego regresu skali finansowania AI. Niemniej średnioroczna złożona stopa napływu kapitału (CAGR) w latach 2016-2022 wyniosła blisko 78%. Problematyczne byłoby znalezienie wielu takich gałęzi gospodarki, do których inwestorzy tak lgną. Widać to wyraźnie na poniższej infografice, gdzie zostały przedstawione transakcje fuzji i przejęć (M&A), na rynku prywatnym (PE/VC) oraz pozostałe. W grupie pozostałych znajdują się m.in. pierwsze oferty publiczne (IPO). To niewielki odsetek finansowania działalności AI. A do tego z dość egzotycznych lokalizacji, gdy spojrzy się na transakcje minionego roku. Kapitał w formie IPO pozyskało wówczas pięć spółek, w czym wiodły prym chińskie korporacje. Znalazły się wśród nich: ASR Microelectronics (1,08 mld dol.), iSoftStone Information Technology (0,73 mld dol.), Fortior Technology (0,30 mld dol.) i Beijing Deep Glint Technology (0,29 mld dol.). Całość uzupełniło saudyjskie Jahez International (0,43 mld dol.).

Wilk jest u drzwi

Z drugiej zaś strony jest pełno obaw w związku z pojawieniem się nowej technologii. Być może ich najlepszym wyrazicielem był New York Post. Dziennik opublikował pod koniec stycznia 2023 artykuł zatytułowany „ChatGPT może uczynić te zawody przestarzałymi: Wilk jest u drzwi”. Od wieków ludzkości towarzyszył lęk przed nowymi technologiami, gdyż niejednokrotnie to oznaczało, że na dotychczas wykonywane zawody nie będzie popytu ze strony przedsiębiorców. Nie inaczej jest w przypadku AI. Wiele profesji jest zagrożonych, a dla innych rozwój sztucznej inteligencji będzie korzystny. Z bodaj najdogłębniejszym badaniem na ten temat zapoznasz się TUTAJ.

Wynika z niego, że najbardziej na baczności powinni się mieć telemarketerzy i nauczyciele (głównie języki obce, literatura i historia). Z kolei najwięcej wiatru w żagle mogą dostać podmioty, które świadczą usługi prawne, w zakresie papierów wartościowych, towarów i inwestycji. Ekonomiści NBER przyjrzeli się zmianom na rynku pracy w latach 1940-2018. Pod uwagę została wzięta populacja amerykańska. Okazało się, że w 2018 r. funkcjonowało 60% stanowisk zupełnie nieznanych w 1940 r. Współczynnik był jeszcze wyższy dla białych kołnierzyków, gdyż wyniósł 74%. A zatem zamiast biadolić i na zapas obawiać się lepiej poświęcić energię na zastanowienie, w którym kierunku podążyć zawodowo w dłuższym terminie. Z wynikami tego badania możesz zapoznać się TUTAJ.

Moje spotkanie ze sztuczną inteligencją

Spotkałem się z ChatGPT i zapytałem ją czym właściwie. Taka padła odpowiedź:

„ChatGPT to duży model językowy wyszkolony przez OpenAI, który jest w stanie generować ludzkie odpowiedzi na zapytania w języku naturalnym. Działa poprzez wykorzystanie architektury głębokiej sieci neuronowej zwanej transformerem, która została przeszkolona na ogromnej ilości danych tekstowych, aby nauczyć się wzorców i relacji między słowami, frazami i zdaniami. […] Zasadniczo ChatGPT działa poprzez przetwarzanie dużej ilości danych tekstowych w celu uczenia się wzorców i relacji między słowami i frazami, których następnie używa do generowania kontekstowo istotnych i spójnych językowo odpowiedzi na zapytania. Rezultatem jest system, który może rozumieć i odpowiadać na zapytania w języku naturalnym w sposób naśladujący ludzką konwersację”.

Jamie Dimon postawił na AI

Ostatnio amerykański rynek finansowy obiegła informacja, że JP Morgan złożył wniosek o rejestrację znaku towarowego IndexGPT. Ten ruch nie jest zaskoczeniem, ponieważ Jamie Dimon, prezes spółki, sygnalizował już istotność sztucznej inteligencji dla losów banku w dorocznym liście do akcjonariuszy, dołączanym do sprawozdania finansowego. Bank żartobliwie, podobnie jak ja, poprosił ChatGPT o odpowiedź na fundamentalne pytanie – Czy sztuczna inteligencja jest dobra dla gospodarki? Aplikacja mu napisała:

„Sztuczna inteligencja (AI) może mieć pozytywny wpływ na wzrost gospodarczy na wiele sposobów:

1) Zwiększona produktywność: AI może zautomatyzować rutynowe zadania i wykonywać je szybciej i dokładniej niż ludzie, co może zwiększyć produktywność i wydajność,

2) Oszczędność kosztów: poprzez automatyzację zadań i procesów, sztuczna inteligencja może obniżyć koszty pracy,

3) Nowe możliwości biznesowe: AI może pomóc firmom zidentyfikować nowe możliwości rozwoju i innowacji,

4) Lepsze podejmowanie decyzji: AI może pomóc firmom w podejmowaniu bardziej świadomych i opartych na danych decyzji. Należy jednak zauważyć, że niektóre branże mogą odnieść większe korzyści niż inne, a także należy wziąć pod uwagę wpływ sztucznej inteligencji na zatrudnienie i nierówności w dochodach”.

W zgłoszeniu rejestracyjnym „błękitnokrwiści” wskazali, że chodzi im o produkt oparty o technologię GPT, a zatem tę, na której bazuje ChatGPT. I na tym się prawie skończyło. Trójsekcyjny wniosek jest napisany na tyle gładko, że nie sposób precyzyjnie wywnioskować, do czego dokładnie potrzebny będzie IndexGPT. Nieco może naprowadzać nazwa produktu. Najbliższe przypuszczeniom zdaje się pozyskiwanie danych rynkowych. Ale to nic pewnego, gdyż w niejaką konfuzję wprowadził rynek Josh Gerben, prawnik JP Morgan, który indagowany przez Barron’s, stwierdził, że aplikacja ma służyć do wyboru papierów wartościowych. Na wprowadzenie IndexGPT przyjdzie najprawdopodobniej trochę poczekać. Mniej więcej rok, gdyż amerykański urząd odpowiedzialny za tę materię jest mocno obciążony mnóstwem wniosków. Z treścią wniosku JP Morgan zapoznasz się TUTAJ.

Nietrudno zakładać, że JP Morgan nie jest jedyną instytucją finansową, która postawiła na sztuczną inteligencję. I tak jest w istocie. Do zdecydowanych działań przystąpiły numer dwa i trzy w światowej bankowości inwestycyjnej. Odbywają się tam testy na użytek wewnętrzny. Informatycy Goldman Sachs (numer dwa) tworzą kod aplikacji, zaś Morgan Stanley (numer trzy) jest na etapie konsultacji z doradcami finansowymi. Pierwszy ze swoim produktem ruszy zapewne JP Morgan. To perspektywa góra roku. A do niego będą dołączać kolejni. W tej całej historii ciekawostką jest to, że władze JP Morgan zakazały swoim pracownikom używania ChatGPT na kanwie zawodowej.